商业社会是讲究的利益平衡,有钱大家赚,可是宗馥莉要的是自己垄断所有的利益。

我们看娃哈哈有几方的利益需要平衡,国资的利益,员工持股的利益,二房的利益,以及创业元老他的那些叔叔辈儿们的利益,但是他这一切全然不顾,居然要掀桌子。他击穿了宗庆后给二房两个儿子留下的信托资产破坏了宗庆后想保持的利益平衡,这个新闻一爆出来,宗庆后的完美人设就崩塌了。

第二,宗馥莉不知道宗庆后留给她最值钱的不是那些土地、厂房、设备,也不是经销商资源。经销商资源都随时可以反叛的,而是娃哈哈这个金字招牌,但是他没有维护好各方的利益,没有维护好宗庆后的个人品牌形象,最后导致娃哈哈的品牌儿也顺带受损。它成了刨坟的第一人,当他掌控不了哇哈哈这个金字招牌的时候,他就泯然众人了。他不再是娃哈哈的公主 ,而变成了一个废长公主。这对宗馥莉来说是最大的损失没有维护好娃哈哈这杆大旗 , 最后的结果就是分崩离析。

我给大家预测一下未来宗馥莉去做娃小宗这个品牌儿真的是一个昏招。

他的另起炉灶严重地损害了娃哈哈大股东杭州上城区国资的利益 势必招致巨大大的反弹。

现在恶果出来了,娃哈哈这个品牌儿的光环被长公主消磨殆尽。

宗馥莉要想借娃小宗这个品牌儿东山再起,难上加难,那就是普通的一个饮用水品牌,你有娃小宗,上海经销商,他的那些堂叔们有沪小娃,军阀混战,渔翁得利,娃哈哈这个品牌儿再也没有机会去战胜农夫山泉。

都说富不过3代,没想到娃哈哈这个品牌儿传到第二代第8个月还没到 就已经轰然倒塌。

宗馥莉辞职给富二代接班留下了巨大的教训,上一代留给你的最重要的是商誉 是无形资产,是没有写进资产负债表中的。如果你学不会和别人分享财富,你就不能乾纲独断,垄断权利,你不会分享财富。别人就会把你逐出决策的权利圈,关于这一点你怎么看?欢迎评论。

众所周知,自动驾驶模式是一种时代的高科技技术,也是未来汽车的主流研发方向,驾驶员不需要手握方向盘,开启这个模式,车子可以自动驾驶。(除去人工驾驶L0)自动驾驶拥有5个级别,那厂商常挂在嘴边的L2级、L3级自动驾驶,分别代表着什么?

L1级别就是车辆给驾驶员一些简单的辅助,具代表的技术就是ACC自适应巡航,通过车身上的雷达系统检测周围路况,实现自动跟车、加速、减速、刹车等。市面上绝大多数车型上都有配备,是基础的驾驶辅助功能。

L2级别可以说达到了半自动驾驶,可以实现车辆对多项功能进行操作,双手可以进行短暂的休息,但仍需做好随时接手驾驶任务的准备。L2级别包括的功能有:全速自适应巡航、自动泊车、主动车道保持、限速识别、自动变道等等。

L3级别可以做到车辆在特定环境中实现部分自动驾驶的操作,可以根据路况环境判断可以自动驾驶还是返回给驾驶员手动操作。来到这个级别,才算自动驾驶的真正开端,车辆几乎可以独立完成全部的驾驶操作,甚至可以刷刷微博。

来到L4级别,可以说是真正意义上的自动驾驶了,不需要驾驶员手动操控,车辆完全可以根据系统的判断瞬时做出正确操作。驾驶者只需要坐在驾驶位上做想做是事情,相当于有个专职司机了。这个级别就是目前汽车自动驾驶的目标了,达到这个级别的车辆,遇到任何场景都不需要人为操作,可以躺在车里睡大觉。

目前,大部分汽车都处在L2级别,但是L3级别的脚步也在加快,甚至物流企业已经应用了L4级别,只是还未能载人。目前的L2、L3虽然便利,但仍存在着风险,当驾驶员接管方向盘时,需要几秒的稳定时间。

根据相关数据显示,印度已经成为加拿大最大的移民来源国之一。

2022年,加拿大接收的印度移民数量达到11.9万人,占当年移民总数的30%。

截至2023年,印度移民人数已从2013年的3.2万人增长至近14万人,十年间增幅高达300%。

不仅如此,2023年通过探亲、陪读、留学等途径进入加拿大的印度人也达到近200万,而加拿大总人口仅有4000多万。

印度人“占领”加拿大?10年间增幅300%?加拿大为何欢迎印度移民?

近日,一张加拿大某高校毕业典礼的照片在网络上掀起了热议。

照片中,绝大多数毕业生都是印度裔,白人几乎难觅踪影,唯有一位黄发韩国女生显得格外突出。

清华大学官方微博也的确说了今年的毕业典礼上授予了 3000 多博士学位(具体的数字是 3168 人)。

不过,2020年毕业典礼授予博士学位人数只有 1018 人。而去年年底的清华大学毕业生就业报告显示,清华这一年实际毕业了博士生 1510 人。

为啥2021年一下毕业3000多人?

因为,清华 2020毕业典礼的时候说了:“由于疫情原因,本次典礼不设学位授予环节。学校决定,在 2021 年 5 月校庆期间和 2021 年毕业季,将为 2020 届毕业生分别安排专场学位授予仪式”。

也就是说,2021年学位授予的 3000 多是两年的博士毕业生数量。因此,博士生学位授予数量,不等于今年的毕业数量。

对比往年校方发布的统计数据,清华一年毕业博士生数量应该在 1500 人左右。北大略少一点,2019 年是 1300 多人。

据统计,2020年:

清华大学共录取3000多名博士;

上海交通大学共录取博士2900多人;

北京大学共录取小3000名博士;

武汉大学共录取2065名博士;

中山大学共录取博士2290人;

华中科技大学共录取博士1993人;

同济大学共录取1806名博士;

哈尔滨工业大学共录取博士1800人;

北京理工大学共录取博士1115人;

西北工业大学共录取博士1016人;

湖南大学共录取博士854人;

上海大学共录取529名博士;

中国石油大学(北京)共录取博士430人;

南昌大学共录取372名博士;

江南大学2020年共录取博士360人;

北京化工大学共录取博士351人;

北京林业大学共录取博士338人;

上海财经大学共录取博士317人;

中国政法大学共录取311名博士;

福州大学共录取博士232人。

即上述20所院校共录取25000余名博士研究生,占全国博士总招生人数的四分之一左右。不过相比另外一家巨无霸来讲,这不算什么。

为了搞明白第一个疑惑,分别借助尚在限次免费的gpt5和自己订阅的gemini 2.5 pro作为工具开始了研究。首先对于10 Gigawatts的解读,两个工具给的解释一致,“吉瓦”(Gigawatt)是一个功率单位,用来衡量电能产生或消耗的速率。

瓦 (W, Watt):功率单位吉 (G, Giga):国际单位制词头,代表“十亿”所以,1 吉瓦 (GW) = 10亿 瓦, 10吉瓦 (10 GW) 就等于 100亿瓦!!

一个功率是100亿瓦的数据中心!简直无法想象。

GPT5很贴心的给出了这个功率数字的具象化描述。如果一个数据中心群持续以 10 GW 运转:年耗电量 ≈ 876 亿度电(kWh)相当于约 2190 万个家庭 一年的用电量(按每户每年 4000 kWh 计算)。

换句话说,这个规模的数据中心几乎相当于一个 中等发达国家的居民用电需求。

至此我的第一个疑惑解决了。紧接着第二个疑惑,为什么GW 描述算力?AI无法给我解答,但通过上面关于GW的解读,我们已经很清楚地看到电力基建已经成为继GPU之后新的核心瓶颈。

通过gpt5和gemini的科普,让我对OpenAI和英伟达的强强联合有点后怕,竟然把AI的门槛提高到这个地步了嘛。Altman一贯很drama,但也很能折腾。年初才和甲骨文与软银宣布在美国搞Stargate,这又和英伟达搞数据中心。左手算力右手数据,年中OpenAI放弃盈利转型,转为公益责任公司(PBC),彻底走上了“AI造福人类”之路。

OpenAI的每一步,似乎都在将自己推上神坛。

最后一个问题,10 GW大约对应多少张 NVIDIA GPU?GPT5给出了明确的计算过程,注意下面的推理过程来自全部来自AI(GPT5),请谨慎观看。

结论先看要点

在合理假设下,10 GW 电力规模 大致对应(理论峰值、非常粗略):

GPU 数量(范围):约 4.8 百万 — 16.7 百万 张 H100 级别 GPU(取决于 GPU 型号/功耗与场内配比假设)。参考值:H100 SXM 变体 TDP 可达 700 W,PCIe 版约 350 W。(NVIDIA)

按 8 卡/节点(例如 DGX/HGX)计:约 59.5 万 — 104 万 台 8-GPU 节点。

理论峰值 (FP8 tensor peak) 算力量级:在上述 GPU 数量与 H100 官方峰值(FP8 ≈ 3,958 TFLOPS,即每卡 ≈ 3.958 petaFLOPS(峰值,FP8))下,总峰值可以达到 数万到数十万 exaFLOPS(理论峰值)(注意这是峰值/理论的 FP8 吞吐量,不是实际训练可持续吞吐)。(Colfax International)

关键点:上面这些都是理论上的“峰值吞吐”或基于电力分配的推断,实际可用于模型训练/推理的算力会低很多(受 PUE、服务器/网络/存储占比、互联延迟、软件效率、实际运算精度限制等多重因素影响)。

我用了哪些合理假设(请务必注意这些会显著影响结果)

1 PUE(数据中心总体效率):默认取 1.2(行业优秀值)。也给出更保守的 1.5 结果作为下限情景。

2 10 GW 表示的是“场外电力能力”(新闻措辞中通常是设施级电力),我们把它作为总输入电力(facility power)。

3 IT(服务器)占总电力比例 = 总电力 / PUE 得到 IT 侧可用功率;再假设 GPU 在 IT 侧耗电占比为 70%(保守情景取 50%)(因为服务器还有 CPU、存储、交换机等)。

4 单卡功耗:以 NVIDIA H100 为参考:SXM 版上限 ≈700 W(高性能数据中心常用),PCIe 版典型 ≈300–350 W。不同卡/代会差别很大。(NVIDIA)

5 每卡峰值吞吐:使用公开 datasheet 给出的 FP8 / FP16 峰值(例如 H100 的 FP8/FP16 极限数)。这类数字是 理论 tensor-core 峰值,真实训练/推理中的可持续吞吐通常远低于这一峰值。(Colfax International)

具体计算(示例,便于复核)

示例用的主场景假设:PUE = 1.2,GPU 占 IT 功耗 70%,H100 SXM TDP = 700 W,H100 FP8 峰值 = 3,958 TFLOPS)

1 总输入电力 = 10 GW = 10,000,000,000 W。

2 IT 可用功率 = 10 GW / PUE = 8.333... GW。

3 假设 GPU 使用占 70% → GPU 专用功率 ≈ 5.833 GW。

4 如果每卡 700 W → GPU 数 ≈ 5.833e9 W / 700 W ≈ 8.33 百万 张。(如果用 350 W/卡,则 ≈ 16.7 百万 张。)

5 峰值算力(FP8,理论):每卡 ≈ 3,958 TFLOPS ≈ 3.958 petaFLOPS;8.33M 卡 × 3.958 PF ≈ 3.298×10^4 exaFLOPS(理论峰值)。

(我也做了更保守情形:PUE=1.5、GPU 占 50%,对应 GPU 数 ≈ 4.76M(700W)—9.52M(350W),理论峰值也相应降低,但仍然极其巨大。)

(上面数字在技术上是可计算的数学乘法,但请记住这是理论极限/峰值的乘法结果,不代表可持续训练吞吐或对外“服务能力”)。

(我在计算中参考了 NVIDIA 官方与多家硬件/第三方资料对 H100 的 TDP 与 Tensor 峰值描述。) (NVIDIA)

为什么“理论峰值”与“实际可用算力”差别会很大(必须强调)

精度不同:FP8/INT8 的峰值远高于 FP16/FP32,训练时并非所有工作都能用最高精度或能持续达到峰值。(Advanced Clustering Technologies)

软件与通信开销:分布式训练需要大量通信(AllReduce、参数同步),网络/互联的带宽与延迟会成为瓶颈。

内存/带宽限制:模型大小、显存、HBM 带宽会限制并行度与利用率。

热与功耗节流:持续满功耗运行不总是可持续或经济(风冷/液冷设计、热限制会影响平均功耗)。

PUE 与基础设施:冷却、配电、冗余等会消耗大量电力,只有一部分电力用于实际 GPU 计算。

因此把 “10 GW” 直译成 “多少张 GPU × 峰值算力” 虽能给出尺量级感知,但不等同于“实际可训练的算力”或“可对外提供的推理吞吐”。

小结

新闻里的 10 GW 更准确地是指 电力/基础设施规模 —— 按当前主流最强 GPU(H100)粗算,可以容纳 数百万到上千万级别 GPU,对应的理论峰值算力巨大(达到极高的 exaFLOPS 级别),但实际训练/推理可用算力会远低于这些理论峰值,受 PUE、卡功耗、互联、软件效率等多项因素限制。

主要有以下原因:

架构革新 基于Ada Lovelace 架构,采用台积电4nm工艺,晶体管数量达到760亿(比上一代RTX 3090的280亿提升近3倍)。 DLSS 3技术支持、帧生成技术,游戏帧率可提升至传统渲染的4倍,尤其在4K/8K分辨率下优势明显。算力碾压3090 FP32单精度浮点性能约 83 TFLOPs(RTX 3090为36 TFLOPs),显存带宽提升至 1 TB/s(GDDR6X 24GB)。 AI与创作场景 Stable Diffusion等AI工具生成图像速度提升3倍以上,Blender渲染效率翻倍。

2.AI算力需求激增

AI领域的“黄金选择” 随着人工智能技术的快速发展,尤其是大模型的普及,对算力的需求呈爆发式增长。RTX 4090显卡凭借其24GB显存和强大的计算能力,成为中小规模AI推理的“黄金选择”,广泛应用于AI模型训练和推理。

算力供需失衡 全球算力需求年增长率已突破58%,而高端GPU产能仅增长21%,供需矛盾推动市场价格剧烈波动。

大模型训练与推理的“平民化”趋势 个人开发者、小团队用RTX 4090替代成本高昂的A100/H100。本地化AI应用(如ChatGPT私有部署)依赖高性能显卡。游戏玩家追求极致体验 支持《赛博朋克2077:超速模式》《阿凡达:潘多拉边境》等光追大作的全特效运行,4K 120Hz成为新标杆。 玩家对高帧率、VR/元宇宙设备的兼容性需求激增。内容创作者刚需 视频8K剪辑、3D建模(Unreal Engine 5)、影视特效(OctaneRender)等场景对显存和算力要求严苛。

3.供应受限与市场策略

出口限制影响 尽管RTX 4090显卡已不在美国的出口限制名单中,但之前的禁令导致市场供应紧张,消费者和企业对供应的担忧依然存在。商家囤货与炒作 部分商家和黄牛囤货居奇,试图通过控制市场供应来抬高价格获利。这种行为导致市场上显卡价格大幅上涨。

竞品真空期 AMD RX 7900 XTX 在光追和AI算力上落后约30%,且发布时间较晚,未能形成有效竞争。 英特尔ARC显卡仍聚焦中低端市场。“卡荒”后遗症 2020-2022年显卡短缺导致玩家升级需求积压,RTX 4090成为“报复性消费”出口。 部分矿工转售旧卡后,选择购入4090作为“战未来”投资。

品牌溢价与稀缺营销 NVIDIA通过限制公版卡供应,推高第三方厂商(华硕、微星等)旗舰型号价格在XXXX以上,塑造“奢侈品”形象。 媒体评测普遍强调“唯一真4K旗舰”,强化用户心智。

4.性价比优势

与新一代显卡的对比 尽管英伟达推出了RTX 5090等新一代显卡,但其价格较高且在AI领域并不一定具备绝对优势。RTX 4090显卡在性能和价格上更具性价比,尤其在AI推理和中小规模模型训练中表现突出。

替代产品不足 国产显卡在性能和生态方面与英伟达显卡仍有差距,难以在短期内完全替代4090显卡。

5.政策与市场环境

政策支持 国家政策对算力基础设施的支持力度不断加大,推动了对高性能GPU的需求。例如,六部门联合印发《算力基础设施高质量发展行动计划》,提出到2025年算力规模超过300 EFLOPS,智能算力占比达到35%。

市场需求多元化 除了AI领域,4090显卡在游戏、专业图形设计等领域也有广泛应用,进一步增加了市场需求。

6.二手市场与租赁市场

二手市场活跃 由于新卡供应受限,二手市场的4090显卡价格也水涨船高,甚至出现了“一卡难求”的局面。

算力租赁需求增加 面对显卡供应紧张和价格高昂的问题,部分企业和用户转向算力租赁平台,租用搭载4090显卡的云主机来满足AI计算需求。

租赁市场的价格传导 算力租赁平台的高需求也进一步推高了4090显卡的市场价格。

综上所述,2025年后国内RTX 4090市场火爆且价格一路狂涨,主要是由于AI算力需求的爆发、供应受限、市场炒作、性价比优势以及政策支持等多方面因素共同作用的结果。

随着自动驾驶技术的发展,高速NOA、城市NOA作为智驾系统中的一项重要技术,其设计初衷是利用高精度地图、传感器融合、深度学习算法及实时环境感知等多重技术实现辅助驾驶,防止驾驶员因长时间驾车出现疲劳驾驶。智驾系统也可以在短时间内检测到交通环境的变化,并发出风险提示,其在数据处理与环境感知方面相较于人类驾驶员也具备一定优势,若正确使用智驾系统,无疑会有效改善交通环境,避免事故的发生。

技术落地到现实,其实会出现很多意想不到的问题,现如今的智驾系统,并不能完全处理各种交通路况,尤其是现阶段智驾系统和人类驾驶员的驾驶权责判定相对混淆。有时遇到突发状况,智驾系统无法处理,便需要人类驾驶员立即介入,人不是机器,需要思考和反应的时间,在提示需要介入时,总会存在一定的时间间隙,若驾驶员来不及反应,反而更容易发生事故。

从小米的说明中也可以看到,从系统发出障碍检测提示到驾驶员实际接管操作再到撞上水泥护栏,仅仅经历了短短的几秒钟时间,这对驾驶员的反应速度和操作准确性提出了极高要求。超高的车速、复杂的交通路况和突如其来的接管提示,或给驾驶员带来较大的心理压力,导致操作上出现犹豫或错误,致使事故的发生。智驾最前沿以为,自动驾驶技术的发展方向不仅在于提升系统自身的感知与决策能力,也在于如何更好地协调系统与驾驶员之间的信息传递和操作衔接,使得驾驶员在接管时能够迅速、准确地判断并作出应对措施。

事故发生在施工路段,其实也反映出当前高精度地图和实时数据融合技术在动态路况下的局限性。施工区域及临时封闭的道路环境并非日常常态,地图数据更新速度和系统对临时障碍物的判断能力都存在一定不足,在边缘场景下,自动驾驶系统的环境识别能力可能受到影响,导致在关键时刻无法及时作出最佳反应。

驾驶员在接管后的操作轨迹显示出其在紧急情况下试图同时进行方向调整与减速,但在高速行驶中操作的惯性与车辆物理特性使得控制效果受到限制。在自动驾驶加速落地阶段,这类的接管需求只会越来越多,如何确保车辆被接管后操作的稳定性也是汽车行业需要研究的一个课题,正如前文所说,突如其来的接管无疑会让人类驾驶员来不及反应,若在高速行驶的情况下瞬间将车辆的所有控制权都交由驾驶员,这无疑增加了事故发生的概率。

这起事故,也说明现阶段大家对自动驾驶的认知度依然不足。我们在刷短视频时,经常会看到宣传脱手车辆自动驾驶的内容,这无疑是在混淆大家对于自动驾驶系统的认知。我们一定要清晰认识到,现在的自动驾驶只是处于L2级别,在这一阶段,驾驶员仍旧需要对车辆的操作负主要责任。作为企业,在宣传智驾系统时,一定不能过度宣传,更要加强智驾系统使用的相关教育,确保驾驶员对自动驾驶系统的功能和局限有足够清醒地认识,避免因过分依赖系统而忽视对道路环境的实时关注。

这一事故或也说明现阶段自动驾驶行业的系统测试与验证机制存在漏洞。当前许多自动驾驶系统在正式商用前,只是在标准路况下进行大量测试,但对于施工区域、临时封闭等非标准路况的测试较少。随着自动驾驶技术的逐步普及,相关测试标准和验证流程亟待进一步完善,确保系统在各种复杂场景下都能保持稳定安全运行。监管部门和行业组织应当联合建立事故数据库,通过对事故案例的深入分析,总结出共性问题,从而推动技术改进和标准制定,使整个行业能够在事故中不断汲取经验,提升整体安全性。

自动驾驶技术的发展不仅是一项科技进步,更是一场驾驶文化和交通管理模式的变革。驾驶员在享受智能化辅助驾驶带来的便捷时,必须时刻保持对道路情况的关注和对系统局限性的警惕。我们必须明确意识到,现阶段自动驾驶系统并不能全权替代人类驾驶,而是处于一种人机协同的驾驶模式。在这种模式下,驾驶员既要信任技术带来的便利,也不能放松对车辆状态的主动监控。只有当技术、管理和驾驶文化三者实现良性互动,自动驾驶技术才能真正成为提高交通安全和出行效率的重要工具。最后,智驾最前沿还是要强调:现在的自动驾驶并不是无人驾驶,切莫过度相信系统能力,智驾是尝鲜的,生命是自己的!

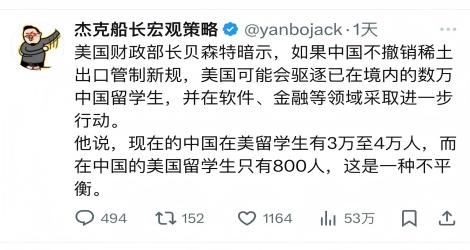

Android 闭源,将会带来怎样的影响?

主要结论:主流手机品牌和它们的用户不需要担心。

首先让我们重温一下Google 和 Android OEM 之间的协议关系:

1.

AOSP,任何厂商都可以使用 AOSP 进行开发,不需要获得Google 的同意;

2.

Android 兼容性承诺协议 ACC、移动应用分发协议 MADA、企业设备补充协议 EDLA 等,不一而足。通过协议,Google 和 OEM 之间建立商业约束。签订了 ACC 协议的 OEM 通过 AOSP 开发的操作系统,才能够称之为 Android 操作系统,获得 Android 商标使用权等权益。

3.

Google 移动服务 GMS,包括Google 服务核心、账号体系等后台功能,以及前台的 Google Play 商城、YouTube、Gmail、Calendar 等应用。公司签署了上述协议,并且手机型号通过了Google 兼容性测试,才可以预装 GMS。

ACC、MADA/EDLA 等协议的组合,确保了Google 对 Android 操作系统有着大体上的绝对控制。

包括小米、vivo、OPPO、三星等在内的当今绝大多数 Android 手机品牌,和Google 都签订了协议。没有意外的话,Google 应该已经联系它们进行安抚,并且确保未来的合作照常进行了。

在过去有相当一部分设备和芯片厂商,它们利用 AOSP 开发产品,却不从 Google 获得 Android 设备认证,设备不需要预装 GMS 全家桶,也能够避开 Google 的认证要求。

非认证 Android 设备五花八门,数以十亿甚至百亿计。通过这次闭源 AOSP,Google 有可能引诱非认证设备厂商向自己低头,签订前面提到的各种协议。

一种极有可能出现的情况是,基于 AOSP 开发的智慧座舱系统,可能代码也不会再无偿提供给全世界的厂商了。除非车企和 Google 签订协议,它们将无法得到最新的代码。当然,车企也可以继续使用已经开源的旧系统开发。

这不是已经发生的事实,只是一种可能性。Google 这次闭源 Android,不排除有一个小的动机就是试图夺回非认证设备市场,或者至少能够从中分一杯羹。这个大市场,虽然是设备厂商自己打下的,但如果没有 AOSP 确实也不会是今天的样子。

顺着这个角度,非认证 Android 设备消费者可能就会受到影响了,当然同样不会很明显。影响主要来自财务方面:OEM 想继续预装 Android 操作系统,就必须要服从 Google 对设备的管理和要求。这个成本当然会被转嫁给消费者,导致支付更高的价格。除此之外,消费者也只能使用 Google Play 等渠道下载应用,第三方应用市场(例如 F-Droid)等的生存空间也变得更少,Google 也可以向所有的应用内支付收一笔费用。

部分厂商可能不愿意屈从 Google,产品退出市场,消费者的选择权就缩减了;但与此同时,任何 Google 在闭源之前已经发布的 AOSP 代码,理论上仍然可以使用。厂商可以随意 fork 代码,自己开发、更新、维护。估计智能冰箱的消费者不会在意冰箱是否预装最新 Android 操作系统。

中国工程院院士、之江实验室主任、阿里云创始人王坚在央视的面对面节目中表示:交通拥堵的根源并非车辆过多,而在于车速过慢,不是因为堵车才慢,而是因为慢才堵车。

这一论断颠覆了“车多必堵”的传统认知。

王坚团队通过卫星图像实测发现,北京市汽车保有量约 700 万辆,但午间 11 点的北京二环主路仅约 6000 辆车就能引发严重拥堵。

这说明在车辆远未达到道路承载极限时就出现了拥堵状况,颠覆了 “车多必堵” 的传统认知。

王坚认为这是低速引起的连锁反应。

车辆低速行驶会降低道路通行效率,引发车流 “堆积” 的恶性循环。

比如一辆车在路口因某些原因减速或犹豫几秒钟,后方的车辆就会跟着踩刹车,这种 “涟漪效应” 在车流量大的早晚高峰会被无限放大,最终形成大面积的拥堵。

王坚用物理学中的 “纳维 - 斯托克斯方程” 来比喻交通流的现象,车流速度每降低 10%,拥堵指数就会指数级暴增。

这意味着即使车辆数量没有明显增加,但只要车速下降到一定程度,就会导致交通拥堵状况急剧恶化。

根据“格林希尔茨模型”(Greenshields Model),当车流密度达到临界值后,车速下降将导致流量骤减,形成“拥堵螺旋”。

例如,一条三车道高速公路:

理想状态:车速80km/h,每小时通行量4,800辆;

速度降至40km/h:通行量暴跌至2,200辆,拥堵指数上升218%。

他分析称,车辆低速行驶会降低道路通行效率,导致车流“堆积”形成拥堵循环。

基于此,王坚提出了 “算力治堵” 方案。该方案通过实时监测全域车辆数量及位置,精准计算各路口可承载的车流阈值,动态调控红绿灯时长,确保车辆以合理速度通过关键节点,从而缓解交通拥堵问题。

王坚强调,该方案依赖城市级算力平台的支撑,需整合卫星定位、物联网及AI算法等技术,未来或为超大城市交通治理提供新路径。

目前,杭州等城市已在试点类似智能交通系统,成效初显。

杭州城市大脑通过实时优化信号灯,将主干道通行速度提升15%,拥堵排名从全国第5降至第57。

王坚的论断“不是因为堵车才慢,而是因为慢才堵车”,看似反常识,实则揭示了复杂系统中效率与资源分配的核心矛盾。

这一逻辑不仅适用于交通领域,更可延伸至云计算、城市治理、商业运营等场景,其本质是对“因果倒置”现象的深度反思。

王坚的洞见挑战了“资源不足导致拥堵”的线性思维,强调效率即容量。

在复杂系统中,速度是流量的函数,而非结果。

无论是代码优化、交通治理,还是组织管理,真正的破局点在于:

识别关键延迟源(如I/O瓶颈、低效流程);

通过技术创新与制度设计加速核心环节;

建立正反馈循环(速度提升→流量增长→资源利用率优化)。

比如在交通领域,要提升平均车速而非一味拓宽道路;在商业上提高效率要通过缩短流程周期而非增加人力。

这一思维模式的价值在于,它提醒我们:解决拥堵的钥匙,往往藏在效率的黑箱之中。

在西方神话中,上帝在创世的第六天用泥土创造了第一个男人,取名为“亚当”,并让他管理人间大地。 为了让亚当有人陪伴,上帝取出亚当的一根肋骨,将其创造成女性,取名为“夏娃”。 亚当和夏娃生活在伊甸园,并且很快产生了爱情,他们不顾上帝警告,私自偷吃了智慧树的果实,虽然获得了海量智慧,但也因此遭到了上帝的惩罚。 亚当和夏娃被上帝逐出伊甸园后,他们开始经历人世间的生老病死,但也因此成为了人类的祖先。

圣经中上帝造人的故事

创世之前,一片混沌,地球在黑暗、沉寂无声的太空飘浮,没有陆地,只有满满的海水。上帝耶和华用六天时间创造了世界。第一天创造了白天和黑夜、第二天创造空气和天;第三天创造了地、海,山川平原,花、草、树木;第四天创造了天上要布满星辰,用来划分季节和年,夜晚是休息的时间,就让宁静的月亮给那些穿越沙漠的漂泊者指明方向,帮他们找到栖身之处;第五天上帝创造了鱼、鸟等各种动物;第六天上帝创造了人;第七天上帝休息了。

梁文峰,被DeepSeek吹起的泡沫送上了天。

2月11日,据彭博社报道,在他们采访了七位初创公司创始人和人工智能专家并进行估算后,认为DeepSeek的市值在10亿美元至1500亿美元之间。

而如果采用更加精准的估值方法的话,DeepSeek的市值大概会在20亿美元至300亿美元之间,如此高的估值也意味着拥有DeepSeek 84%股权的梁文峰将跻身亚洲最富有的科技大亨行列。

波士顿风险投资公司Glasswing Ventures的创始人兼执行合伙人Rudina Seseri表示::“即便保守估计,这家公司仅凭目前区区数百万美元的营收,就能轻松获得数十亿美元的估值,更不用说还要考虑未来增长了。”

而加拿大一家电信公司Sweat Free Telecom的创始人weat Free Telecom则给出了更为夸张的预测,他认为DeepSeek的估值能达到OpenAI最新3000亿美元估值的一半。

如果这一数字成真,梁文峰持有的股份价值将达到1260亿美元,甚至已经超过了身价1180亿美元的英伟达CEO黄仁勋。

不过,要对梁文峰的身家进行准确估值并不容易,因为DeepSeek目前未接受外部融资,完全依赖创始人梁文峰旗下量化对冲基金“幻方量化”的利润支撑。这种模式使得DeepSeek在财务上保持了较高的独立性。

但不可否认的是,梁文峰的身价已经在这一轮DeepSeek吹起的泡沫中,直冲云霄。

特朗普政府取消“小额豁免”后,所有中国商品需缴纳10%关税,且需正式报关,导致跨境电商成本上升,低价商品(如Temu、Shein销售的产品)受影响显著

万万没想到!一家小公司网站被“搞崩”,罪魁祸首竟是OpenAI的爬虫工具——GPTBot

这起事件不仅引发了技术圈的广泛讨论,也让人们重新审视了 AI 公司在抓取互联网数据时可能引发的风险和争议。

(GPTBot是OpenAI早年前推出的一款工具,用来自动抓取整个互联网的数据。)

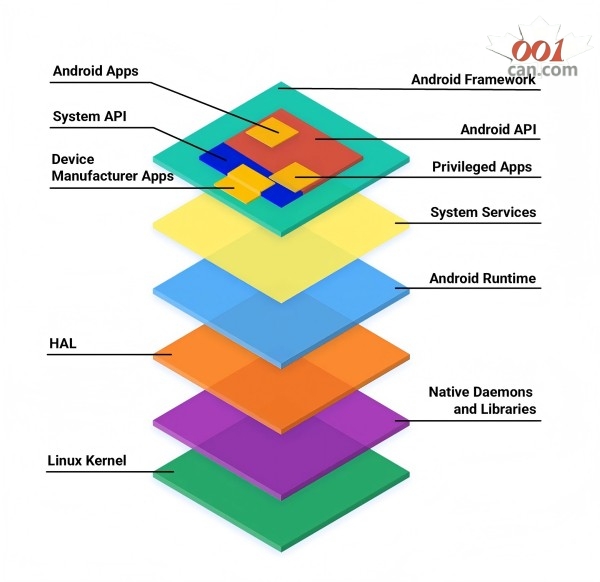

“疯狂的爬虫”如何让小公司网站宕机?

事件的起因看似简单,但背后却暴露了大模型公司对高质量数据的“饥渴”。作为一个只有 7 人团队的小型初创公司,Triplegangers 的网站承载着他们十多年的心血,主要提供高质量的 人类数字孪生数据库。网站内容包括由真人扫描生成的 3D 图像,以及覆盖种族、年龄、体型、纹身、疤痕等细致标签的数据,为 3D 艺术家、游戏设计师等用户群体提供服务。

然而,几天前,团队突然发现,网站的访问速度急剧下降,页面无法正常加载。CEO 和团队连夜检查服务器日志,最终锁定了“罪魁祸首”——OpenAI 的 GPTBot。

疯狂的爬虫行为

根据团队分析,GPTBot 的爬取行为堪称“狂野”:

网站上有超过 65000 种产品,每种产品都有独立页面,每个页面包含至少 3 张图片。

OpenAI 的爬虫试图抓取包括数十万张图片在内的所有数据,同时还试图获取详细的描述内容。

一周之内,他们的日志显示,GPTBot 使用了 超过 600 个 IP 地址 发起了 数以万计的请求。

△Triplegangers服务器日志:OpenAI机器人未经许可疯狂爬虫

这一系列行为直接导致了服务器资源的过度消耗,使网站不堪重负而宕机。CEO 直言,这简直就是一次未经授权的 DDoS 攻击。

宕机背后,资源开销剧增

宕机带来的影响并不仅仅是用户无法访问网站那么简单,更严重的是对公司成本的冲击。由于爬虫行为引发了超负荷的 CPU 使用以及大量的数据传输,Triplegangers 在 AWS 上的云资源费用暴涨。这对于一家小型初创团队来说,无疑是巨大的经济负担。

CEO 表示:“我们不仅为 OpenAI 的爬虫行为付出了网站瘫痪的代价,更不得不承担巨额的服务器成本。更令人懊恼的是,我们甚至不知道 OpenAI 爬取了哪些数据,根本联系不上对方,也无法获取任何解释或补偿。”

也有网友现身表示有类似的经历,自从阻止了大公司的批量AI爬虫,省了一大笔钱:

为什么小公司会成为目标?

OpenAI 的爬虫为什么会盯上 Triplegangers?答案在于数据的价值。

Triplegangers 的数据库是他们 10 多年努力的成果,号称全球最大的人类数字孪生数据库。这些数据包括高分辨率的 3D 图像,以及详细的标签化信息。对 AI 公司而言,这些 高质量、精细化的数据 无疑是训练大模型的“香饽饽”。尤其是在目前高质量数据稀缺的情况下,像 Triplegangers 这样的小型网站,常常成为爬虫的目标。

尽管 Triplegangers 的服务条款中明确写道 禁止未经许可抓取网站数据,但事实证明,这样的声明对 GPTBot 并没有约束力。

未配置 robots.txt,成为“爬虫漏洞”

更深层次的原因在于,Triplegangers 没有正确配置一个关键文件——robots.txt。

robots.txt 是一个标准协议,用来告诉爬虫哪些内容允许或禁止抓取。如果网站未设置 robots.txt,爬虫工具往往会默认认为可以抓取网站上的所有数据。

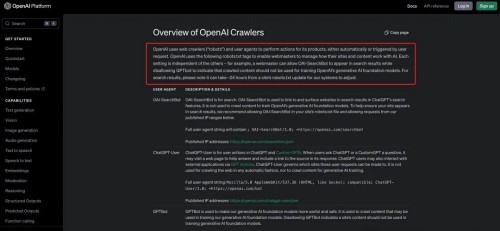

对于 OpenAI 的爬虫工具,阻止抓取的方式如下:

在 robots.txt 文件中添加禁止标签,明确声明 GPTBot 不得访问。

除了 GPTBot,OpenAI 还有其他爬虫工具,如 ChatGPT-User 和 OAI-SearchBot,它们也需要分别在 robots.txt 文件中设置相应的限制。

然而,即使立即添加了 robots.txt 文件,爬虫的抓取行为也不会立刻停止,因为 OpenAI 的系统可能需要 24 小时 才能识别和更新。

CEO老哥对此表示:

如果一个网站没有正确配置robots.txt文件,那么OpenAI和其它公司会认为他们可以随心所欲地抓取内容。

这不是一个可选的系统。

正因如此,也就有了Triplegangers在工作时间段网站被搞宕机,还搭上了高额的AWS费用。

截至美东时间的本周三,Triplegangers已经按照要求配置了正确的robots.txt文件。

以防万一,团队还设置了一个Cloudflare账户来阻止其它的AI爬虫,如Barkrowler和Bytespider。

虽然到了周四开工的时候,Triplegangers没有再出现宕机的情况,但CEO老哥还有个悬而未决的困惑——

不知道OpenAI都从网站中爬了些什么数据,也联系不上OpenAI……

而且令CEO老哥更加深表担忧的一点是:

如果不是GPTBot“贪婪”到让我们的网站宕机,我们可能不知道它一直在爬取我们的数据。

这个过程是有bug的,即便你们AI大公司说了可以配置robots.txt来防止爬虫,但你们把责任推到了我们身上。

最后,CEO老哥也呼吁众多在线企业,要想防止大公司未经允许爬虫,一定要主动、积极地去查找问题。

宕机并非个例,AI 爬虫屡惹争议

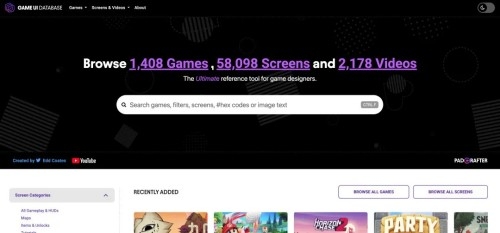

Triplegangers 的遭遇并非孤例。在此之前,Game UI Database 的团队也曾被 GPTBot 搞得焦头烂额。这家专门收录游戏用户界面截图的数据库网站,某天突然发现:

网站页面加载速度变慢三倍;

用户频繁遇到 502 错误;

服务器首页每秒被请求重载 200 次。

经检查发现,正是 OpenAI 的爬虫每秒发起两次请求,直接导致了网站的几乎瘫痪。

不止 OpenAI,其他 AI 公司也“疯狂爬取”

事实上,类似问题并不只存在于 OpenAI。以下是其他公司被曝光的案例:

数字产品工作室Planetary的创始人Joshua Gross曾表示过,他们给客户重新设计的网站上线后,流量激增,导致客户云成本翻倍。

经审计发现,大量流量来自抓取机器人,主要是Anthropic导致的无意义流量,大量请求都返回404错误。

针对这一现象,来自数字广告公司DoubleVerify的一份新研究显示,AI爬虫在2024 年导致“一般无效流量”(不是来自真实用户的流量)增加了86%。

AI公司疯狂爬虫背后的真相

为什么 AI 公司对网络数据如此“疯狂”?

核心原因是 高质量数据的匮乏。

一项研究指出,到 2032 年,全球用于 AI 模型训练的可用数据可能会枯竭。这一预期迫使 AI 公司加快数据收集速度,甚至开始直接购买未公开的内容。例如:

针对 YouTube、Instagram、TikTok 平台上的未发布视频,AI 公司开出了每分钟 1~4 美元 的高价。

根据视频质量和格式,价格还可能进一步提升。

对 AI 公司而言,只有掌握更多独家数据,才能在大模型竞争中占据先机。

小企业如何保护自己?

Triplegangers 的 CEO 最后呼吁在线企业采取主动措施,防止类似事件再次发生。以下是一些可行的防护策略:

正确配置 robots.txt 文件

确保明确声明哪些内容不允许爬虫访问。

部署防护工具

使用 Cloudflare 等流量监控工具,限制不正常的爬虫行为。

定期检查日志

分析服务器日志,识别异常流量和爬虫行为。

主动制定数据保护政策

在服务条款中清楚说明禁止未经许可抓取,并采取技术措施加以落实。

AI 爬虫的行为究竟是技术进步的必然,还是未经授权的数据“窃取”?在数据驱动的 AI 时代,这一问题不仅关乎技术发展,也涉及法律、伦理与商业规则的博弈。

你怎么看待这一现象?如何在技术与隐私之间找到平衡?欢迎在评论区留下你的观点。

一、纯原版ChatGPT、Claude

官网原生页面

真实Team会员账号

二、技术支持

✔️支持GPT-4o、o1、Canvas、Claude

✔️无需魔法

✔️个人独享

✔️24小时300次

✔️Open Ai官网ChatGPT Plus账号,20美元/月,算上其他成本,最低180元/月,我们直接99元/月,并且质保30天

三、支持所有GPTs

支持ChatGPT所有插件,可创建自己的ChatGPT插件,使用朋友分享的自定义插件。

当然也包含最强编程插件Code Copilot。

置之死地而后生,TikTok活过来了!

这是中国公司第一次,正面硬刚美国的制裁令,还赢得了胜利。可TikTok是怎么做到的呢?

这里面,至少有三条对抗线。

第一条对抗线是,司法对抗。针对TikTok的封禁,是拜登签字,美国国会投票通过,还取得了美国最高法的一致支持。这个封禁令,已经不是行政范畴了,而是变成了一条美国法律。在司法对抗上,TikTok几乎是完败。可美国不是一个司法至上的国家,也不是一个纯粹的法治国家。像拜登的儿子被法院判有罪,拜登一样可以利用特赦令,赦免自己的儿子。特朗普呢?同样被美国法院定为罪犯,却能凭借总统豁免权,不用接受任何处罚。也就是说,在美国,法律是可以被突破的。美国是三权分立的,司法权、立法权和执法权,不在一个体系里面。

当司法、立法都无法被推翻时,执法权的分离却让TikTok抓住了一线生机。这就是第二条对抗线:行政对抗。拜登有权封杀TikTok,特朗普也有权解封TikTok。任何一条法律,都需要有人去执行。但特朗普一上来就宣布,美国政府拒不执行这条封杀令。相反,特朗普还承诺,任何美国公司支持TikTok恢复服务,都不需要承担任何代价。

三是,支持美国中小企业。

美国和中国一样,大型互联网平台都垄断了流量,很多中小企业在Facebook、youtube、谷歌等大平台上,都已经赚不到钱了,获客成本太高了。但TikTok的出现,打破了美国本土互联网平台对流量的垄断,超过700万家美国小微企业,在TikTok上获得客户,维持自己的生计。这是一个庞大的商业生态。封杀TikTok,就等于让这个商业生态,遭遇“突发性脑死亡”。这也就是队长要讲的第三条战线:人民战线。TikTok充分赢得了美国人民的支持。当TikTok宣布关闭倒计时后,大量美国网友涌入中国小红书。为什么?因为他们不愿意再被美国传统媒体所欺骗了,也不愿意再活在犹太媒体的信息茧房里了。TikTok就是他们在美国,最大的一个发声筒了。要是没有了TikTok,美国的舆论就又被本地资本家所垄断了。

问 中国稀土新规 让美国震惊的背后